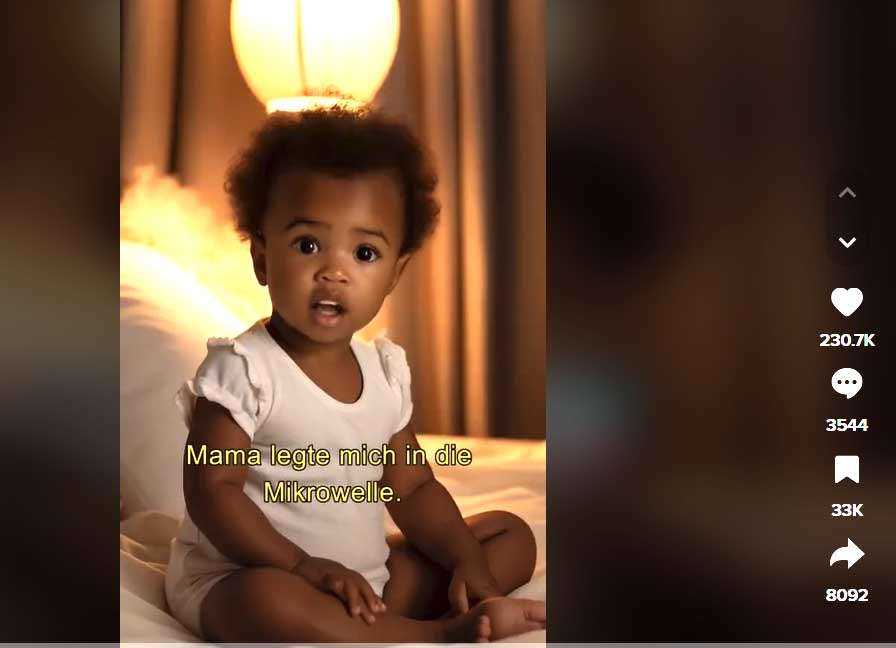

„Mama legte mich in die Mikrowelle“ – mit Sätzen wie diesen beginnen derzeit Kurzvideos auf Tiktok. Verstorbene Kinder und Jugendliche berichten detailliert von ihrer grausamen Ermordung, von Vergewaltingungen und Folter. Es gibt noch deutlich krassere Geschichten als die vom Mikrowellenmord!

Alle Videos tragen den Hinweis:

„Dieses Video wurde mithilfe von Kl erstellt. Es handelt sich hierbei um eine Darstellung und nicht um ein Foto, um die Privatsphäre der Familie zu respektieren. Das Ziel besteht darin, die Geschichte auf eine immersive Weise zu teilen.“

Bemerkt habe ich den katastrophalen Trend dank eines Videos der Grafikerin Jasmin Gnu: „So dreist wird künstliche Intelligenz jetzt eingesetzt!„. Abgesehen von der Grusligkeit und Unverschämtheit der „Darstellungen“ hebt sie hervor, dass diese Videos einfach so im Stream erscheinen: Man muss nicht erst drauf klicken wie auf Youtube, sondern „wischt“ von unten nach oben zum nächsten, das der Algorithmus aufgrund der jeweiligen Popularität nach vorne bringt. Erst das süße Katzenvideo, dann die Mikrowelle… Der Gipfel der Absurdität: Ein solches Opfer beendet seine furchbare Story noch mit dem Satz: „Wenn es Euch gefallen hat, lasst gerne ein Like und ein Follow da!“.

Wieder einmal stelle ich fest: Was eine neue Technik ermöglicht, wird auch gemacht – und zwar sofort! Die Vorstellung, dass nur einige wenige besonders gewitzte Personen sich binnen einiger Monate einarbeiten und solchen Dreck produzieren, ist abwegig. Der hohe Aufmerksamkeitswert solcher Storys verspricht unzählige „Views“ und somit auch Geld. Wie es den Angehörigen geht, die sich das ansehen, ist egal.

Stimmen synthetisieren

Jedes Bild einer Person kann jetzt mittels KI zum Sprechen animiert werden. Vielerlei Stimmen stehen zur Wahl, man kann aber auch eigene synthetisieren. Dadurch ist es z.B. machbar, die eigene Stimme in beliebigen anderen Sprachen sprechen zu lassen (Hier ein Beispiel), eine Anwendung, die es ermöglicht, verschiedene Sprachversionen derselben Rede anzubieten, ohne dass ein Mensch dazu gebraucht würde.

Wenn jetzt viele ihre eigene Stimme auf Plattformen wie ElevenLabs synthetisieren lassen und die Ergebnisse hier oder da veröffentlichen, kann damit gerechnet werden, dass in Zukunft die originalen Stimmen Verstorbener zu hören sein werden. Stimmen, die lange schon „öffentlich“ sind, stehen zur freien Verfügung. Prominente wie Elvis und Mariln Monroe werben bereits für Toaster Churros (frittierte Teigstangen), in Szene gesetzt von einer Berliner Agentur, die dazu schreibt:

„Die KI-Motive bieten uns viel Spielraum, sodass wir sie vom klassischen Asset über Animationen bis hin zu OOH flexibel einsetzen können. Als Kreativschaffende profitieren wir in vielerlei Hinsicht von der Unterstützung durch künstliche Intelligenz, insbesondere im Bereich der Content Produktion. Sowohl bei Text- als auch Bild-Content liegt die Verantwortung für die abschließende Bearbeitung aber selbstverständlich weiterhin bei uns. Die Überprüfung des Contents auf Korrektheit, Glaubwürdigkeit und Qualität ist essenziell.“

Na dann ist ja alles gut? Wenn eine bekannte Person im Video „aufregende“ Sache sagt, müssen wir seit einiger Zeit immer mitdenken: Es könnte eine KI am Werk gewesen sein! Aber tun das auch alle? DeepFakes unterminieren die Glaubwürdigkeit, die bewegte Bilder und Stimmen im Vergleich zu Fotos noch lange hatten – vorbei!

Das alles gab es schon immer, mag man jetzt denken. Und es geht auch mit klassischen Methoden, wie etwa dieses – als „Satire“ gemeinte, aber nicht gekennzeichnete „Mem“ zeigt.

Wer Precht nur aus den ihn betreffenden Shitstorms „kennt“, kann das locker für echt halten, zumindest solange die Kommentare nicht gelesen werden. Hätte man per KI Prechts Stimme und Bewegung „dargestellt“, würde die Aussage jedenfalls noch weit glaubwürdiger wirken.

Wie soll das alles reguliert werden?

Als das World Wide Web Mitte der 90ger das Internet massentauglich machte, herrschte bezüglich der Inhalte ebenfalls die sogenannte „Wild-West-Mentalität“. Wenige Jahre war das Web ein „rechtsfreier Raum“, in dem schier alles möglich war. Das hat sich im Lauf der Zeit zurecht geschüttelt, Kriminelles wanderte ins DarkWeb ab. Ich hoffe, in Sachen KI wird es ebenso verlaufen. Wir brauchen angepasste Gesetze, etwa über den Gebrauch von Stimmen (Lizensierung), Animationen und persönlichen Geschichten: Wenn die Angehörigen zustimmen, mag ein „totes Kind“ seine Story erzählen. Ob es aber erlaubt bleiben soll, dass Kinder per Tiktok einfach so mit widerlichen Gewalttaten konfrontiert werden dürfen, bleibt als offene Frage.

Diesem Blog per E-Mail folgen…

Diskussion

Kommentare abonnieren (RSS)

9 Kommentare zu „TikTok-Trend: Tote Kinder reden“.